一、核心前提:MySQL 原生是否支持「流式查询」?

MySQL 本身无服务器端流式查询能力,仅客户端可通过配置实现「流式读取」,二者的核心区别直接决定了 2000 万条数据查询的异常表现:

表格

二、2000 万条数据查询的异常表现(是否撑爆 / 触发 OOM?)

1. 服务器端:极少直接 OOM,核心问题是「IO 假死 / 超时 / 磁盘飙满」

核心原因:MySQL 服务器不会将 2000 万条数据(假设单条 1KB≈20GB)全部加载到内存,而是将超出内存缓冲区(sort_buffer/join_buffer)的部分写入临时磁盘文件;大量数据的磁盘读写会导致磁盘 IO 100% 占满,服务器进程阻塞(假死),查询超时、连接断开,甚至数据库服务卡顿。OOM 触发条件(极少见):仅当服务器内存极小(如 4GB 以下)且临时磁盘空间不足时,才会因内存 / 磁盘资源耗尽触发 OOM。2. 客户端:未开流式读取必触发 OOM,开流式则无风险

缓冲读取(默认):如 JDBC 默认配置、Navicat/DBeaver 等 GUI 工具,会一次性接收服务器推送的全量 2000 万条数据,数据量远超客户端进程 / JVM 内存上限(如 JVM 堆内存仅 8GB),直接触发 OOM(内存溢出)。流式读取(显式配置):如 mysql 命令行(默认开启)、JDBC 手动配置流式查询,会逐批 / 逐行接收数据,处理完一批释放一批内存,内存占用恒定(仅几十 KB~ 几 MB),不会 OOM。三、分维度解决方案(针对性解决服务器 / 客户端问题)

1. 服务器端:解决 IO 假死 / 超时(唯一根本方案:拆分查询)

核心逻辑:将 2000 万条数据拆分为小批次(如每批 1 万条),让服务器每次仅处理少量数据,避免全量数据触发大量磁盘 IO。

# Shell脚本分批次查询(按自增主键拆分,通用最优方案) #!/bin/bash # 配置MySQL连接信息 MYSQL_USER="root" MYSQL_PWD="你的密码" MYSQL_DB="目标数据库" TABLE_NAME="目标表" RESULT_FILE="query_result.txt" # 配置分批参数:每批1万条,总数据2000万条 start_id=1 batch_size=10000 total_data=20000000 # 循环分批次查询 while [ $start_id -le $total_data ]; do end_id=$((start_id + batch_size - 1)) # 小批次查询:服务器仅加载1万条数据,无大量临时磁盘IO mysql -u${MYSQL_USER} -p${MYSQL_PWD} -D${MYSQL_DB} -N -s -e \ "SELECT * FROM ${TABLE_NAME} WHERE id BETWEEN ${start_id} AND ${end_id};" >> ${RESULT_FILE} # 打印进度(可选) echo "已查询:id ${start_id} ~ ${end_id},进度:$((start_id*100/total_data))%" # 更新起始ID,休眠0.2秒降低服务器压力 start_id=$((end_id + 1)) sleep 0.2 done echo "2000万条数据查询完成,结果已写入${RESULT_FILE}"

适配无连续主键场景:若无自增 ID,可按时间字段拆分(如按创建时间分天 / 小时查询):

-- 示例:按create_time分批次查询(每批1小时数据) SELECT * FROM big_table WHERE create_time BETWEEN '2026-01-01 00:00:00' AND '2026-01-01 01:00:00';

2. 客户端:解决 OOM(强制开启流式读取)

不同客户端的流式读取配置方式:

表格

3. 服务器端兜底优化(缓解 IO 压力,非根本方案)

调整 MySQL 配置参数,减少临时磁盘 IO 开销,避免服务器假死加剧:

# my.cnf / my.ini 配置 [mysqld] # 临时文件目录指向高速磁盘(如SSD),降低IO耗时 tmpdir = /data/mysql_tmp # 内存临时表上限,超出则写入磁盘(不宜过大,避免占用过多内存) tmp_table_size = 64M max_heap_table_size = 64M # 排序/读取缓冲区大小,避免单查询占用过多内存 sort_buffer_size = 1M read_buffer_size = 1M # 关闭不必要的预读,减少磁盘IO innodb_read_ahead_threshold = 0 # 限制单查询的并行度,避免抢占资源 innodb_thread_concurrency = 8

四、关键注意事项(避坑点)

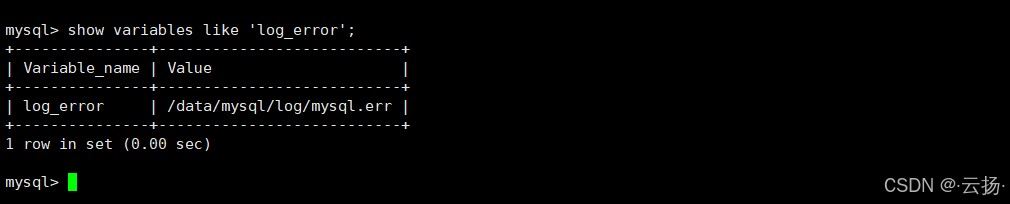

流式读取仅保护客户端:客户端开启流式读取只能避免自身 OOM,无法解决服务器端 IO 假死,必须配合分批次查询;LIMIT + OFFSET 慎用:OFFSET 越大,服务器仍需扫描更多数据(如 OFFSET 100 万会先扫描 100 万条再跳过),仅适合中小批次(<10 万条);避免排序 / 聚合操作:带 ORDER BY/GROUP BY 的查询会让服务器先加载全量数据排序,即使分批次也会触发大量 IO,需优先拆分后再在客户端聚合;监控服务器资源:查询期间监控服务器磁盘 IO(iostat)、内存(free)、MySQL 进程状态(show processlist),避免资源耗尽。五、最终核心结论

异常本质:

服务器端:2000 万条数据查询→大量临时磁盘 IO→IO 打满→进程假死 / 超时(极少 OOM);客户端:未开流式读取→一次性缓存全量数据→OOM(开流式则无风险)。核心解决方案:

服务器端:按主键 / 时间分批次查询(每批 1 万条),从根源减少磁盘 IO;客户端:强制开启流式 / 无缓冲读取,避免 OOM;辅助优化:调整 MySQL 参数,缓解服务器 IO 压力。关键原则:MySQL 不适合一次性处理超大结果集,必须通过「分批次查询 + 客户端流式读取」组合方案,才能避免服务器假死和客户端 OOM。

到此这篇关于MySQL查询2000w超大数据的解决方法的文章就介绍到这了,